|

Основные модели образования – Организация учебного процесса

Основные модели образования

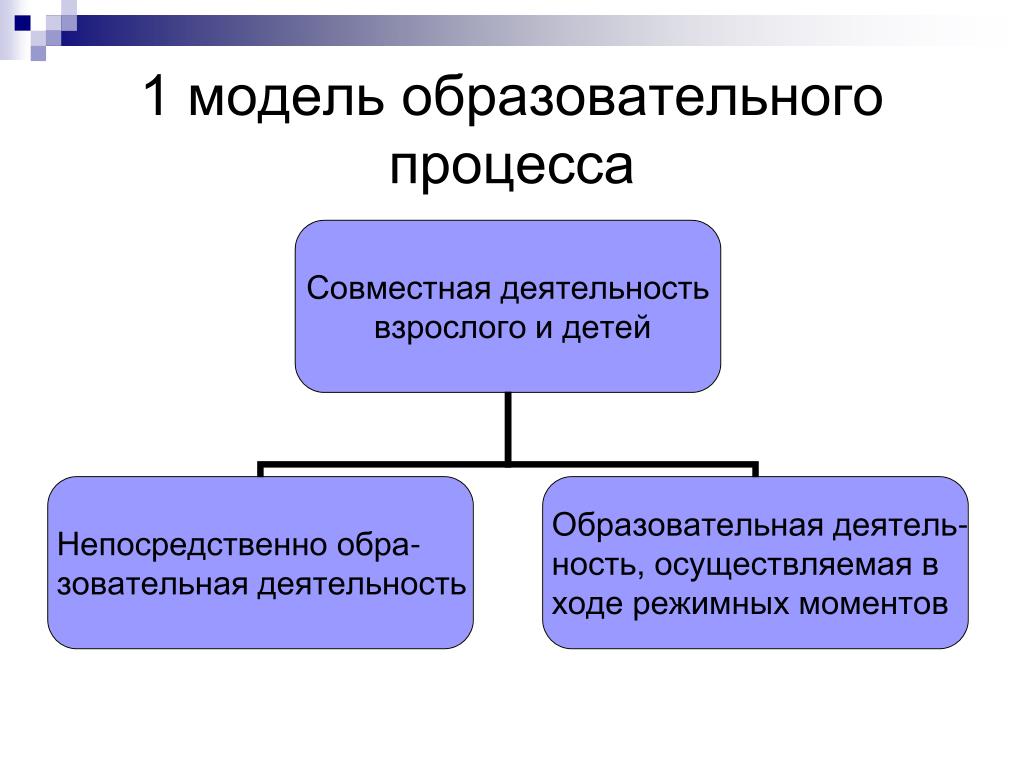

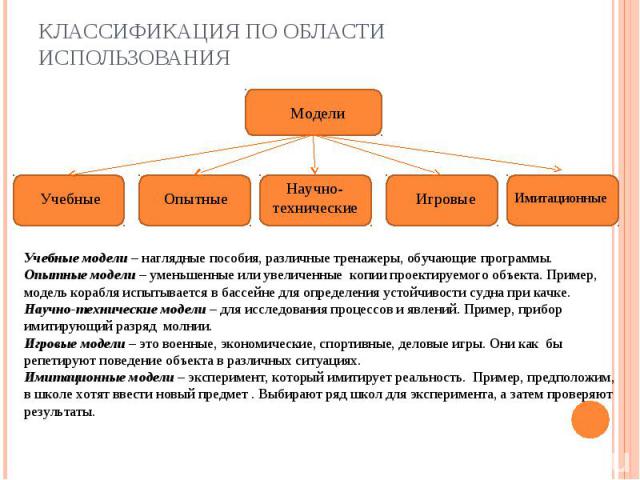

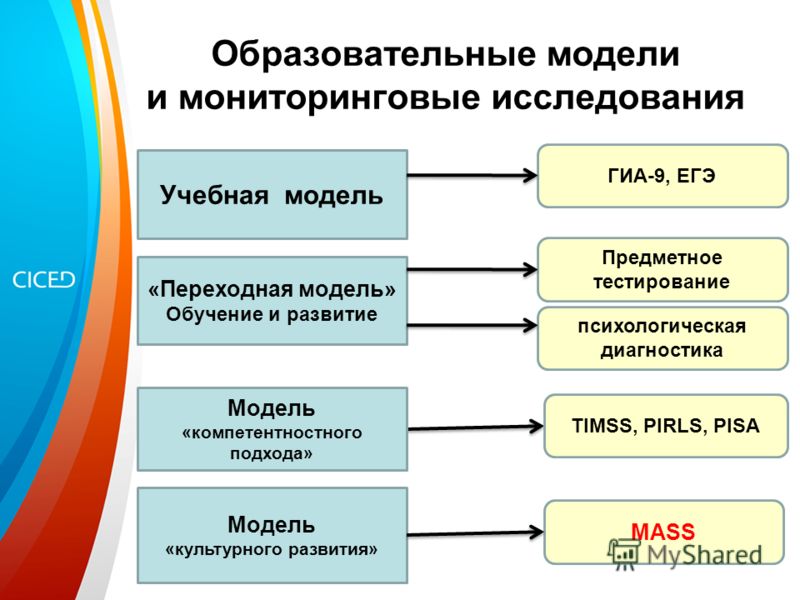

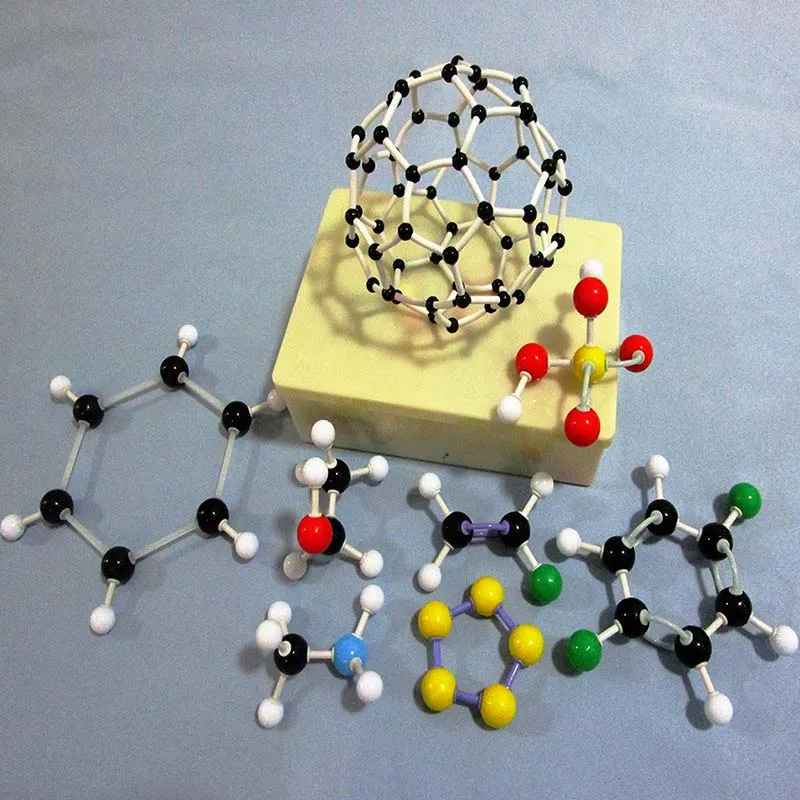

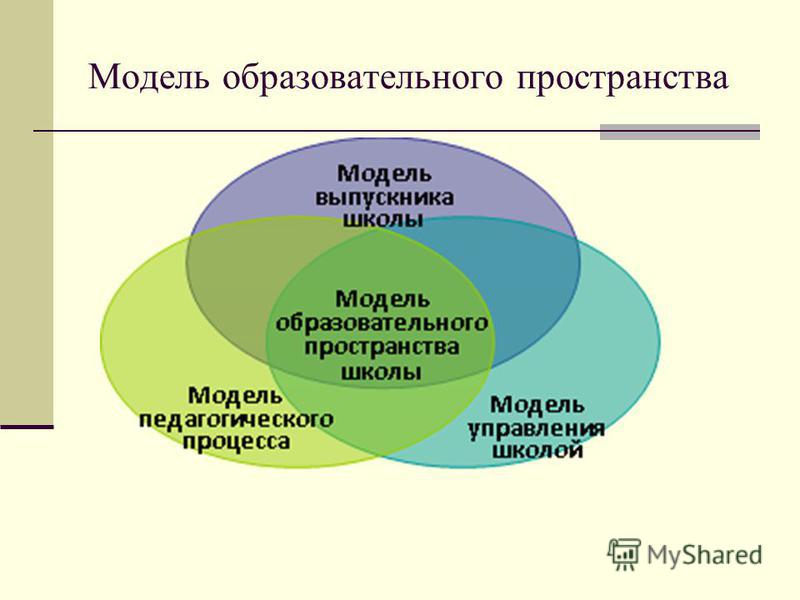

Робот подобрал для Вас материалы, похожие на этот. Посмотреть По материалам моих лекций В педагогической литературе часто встречаются термины модель образования (образовательная модель) и модель обучения. Под моделью образования, как правило, понимается модель, отражающая те или иные представления об организации образовательного процесса в целом, включая не только обучение, но и воспитание, развитие личности. Характеризуя модель образования, некоторые авторы рассматривают её как реализацию определённого научного подхода, как особый способ организации образовательного пространства, взаимодействия различных образовательных организаций и построения системы образования. Модель образования – это мысленно представленная система, отражающая тот или иной подход к образованию, взгляд на его роль в жизни человека и общества. Есть несколько подходов к выделению моделей образования. Так, М. В. Кларин считает, что все образовательные модели можно разделить на традиционные («знаниевые», целью которых является формирование у учащихся знаний, умений и навыков) и инновационные (развивающие, направленные на развитие личности ученика). В ряде научных публикаций модели образования подразделяются на технократические и гуманистические. Главными педагогическими ценностями в технократических моделях являются знаний, умения и навыки (ЗУНы). Основные педагогические ценности гуманистических образовательных моделей – личность ребёнка, её гармоничное развитие (И.П. Подласый). Н. В. Бордовская и А. А. Реан выделяют следующие модели образования. Модель образования как государственно-ведомственной организации. В этой модели образование выступает одной из отраслей народного хозяйства и строится по ведомственному принципу с жёстким централизованным определением целей и содержания образования, типов образовательных организаций и состава учебных дисциплин для каждого типа. Модель развивающего образования (В. В. Давыдов, В. В. Рубцов и др.) отличается кооперацией образовательных организаций разного типа и уровня. Это расширяет спектр образовательных услуг и максимально удовлетворяет потребности в образовании у различных слоёв населения. Кроме того обеспечивается способность быстро реагировать на постоянно происходящие в обществе изменения спроса на те или иные профессии и специальности. Однако и у этой модели есть недостатки. Так, её реализация невозможна без соответствующей инфраструктуры, без развитой сети образовательных организаций разного типа и профиля. Применительно к России с её большими и неравномерно населёнными территориями очень сложно создать такую инфраструктуру, которая обеспечивала бы всем жителям страны равные возможности в получении образования, ориентированного на максимальное развитие личности. Модель систематического академического образования (Ж. Мажо, Л. Кро, Д. Равич и др.) считается традиционным способом передачи новому поколению культурного опыта прошлого. Данная модель нацелена на формирование системы базовых знаний и умений, позволяющих индивиду в дальнейшем перейти к самостоятельному усвоению знаний, ценностей, опыта. Для традиционной модели характерно многообразие усваиваемогго материала; это обусловлено тем, что традиционном образовании заранее неизвестно, что именно понадобится каждому человеку в дальнейшем, обширная программа даёт личности ученика более широкие возможности для дальнейшего самоопределения. Таким образом, главное достоинство традиционной модели – научная основа формируемых знаний и опыта и систематический характер полученного индивидом образования. Недостаток: ориентированность в большей степени на некий идеальный уровень образованности, а не реальные жизненные потребности. Рационалистическая модель (П. Блум, Р. Ганье и др. Феноменологическая модель (А. Маслоу, А. Комбс, К. Роджерс и др.) основана на персональном обучении, учитывающем индивидуальные психологические особенности учащегося, на уважительном отношении к его интересам и потребностям. Приверженцы феноменологической модели отвергают взгляд на школу как на «образовательный конвейер» (само название модели – производное от слова «феномен» – свидетельствует о том, что каждый ученик уникален). Неинституциональная модель (П. Гудман, И. Иллич, Ф. Клейн и др.) – это образование вне школ, вузов и других социальных институтов: дистанционное обучение, обучение через книги, средства массовой информации, мультимедийные учебники, сеть Интернет и т.п. Очевидный плюс данной модели – максимальная свобода выбора обучающимся места, времени, профиля и способа обучения, возможность обучаться вне зависимости от места проживания. Однако свобода является плюсом при условии, что человек готов самостоятельно организовать свою учебную деятельность, а это возможно только, когда он уже имеет солидный опыт учения и сильную мотивацию самообразования. Кроме того, непривязанность обучения к какому-либо социальному институту лишает неинституциальное образования официального статуса и не позволяет обучающемуся получить документ об образовании государственного образца. Таким образом, любая из существующих сегодня моделей образования имеет как достоинства, так и недостатки. Поэтому в развитых системах образования можно встретить различные модели, в том числе – новые, возникающие на основе вышеописанных. Например, среди тенденций последнего десятилетия – включение университетов в развитие дистанционного образования в сети Интернет. Университетское образование относится к традиционной модели, а дистанционное – к неинституциональной. Их слияние позволяет преодолевать недостатки, присущие каждой из этих моделей в отдельности (например, обучаясь дистанционно, получить диплом о высшем образовании или освоить практикоориентированный курс на университетской образовательной онлайн-платформе). Робот обнаружил, что со статьёй “Основные модели образования” тематически связаны: Для ссылки: Сидоров С.В. Основные модели образования [Электронный ресурс] // Сидоров С.  В. Сайт педагога-исследователя – URL: http://si-sv.com/publ/osnovnye_modeli_obrazovanija/14-1-0-504 (дата обращения: 20.09.2022). В. Сайт педагога-исследователя – URL: http://si-sv.com/publ/osnovnye_modeli_obrazovanija/14-1-0-504 (дата обращения: 20.09.2022). | |

| Автор(ы): Сидоров С.В. | Опубликовано 23.09.2015 | Просмотров: 97199 | |

31. Учебные компьютерные модели

Непрерывное и быстрое расширение областей исследования, в которых удается эффективно использовать математические методы, составляет одну из характерных черт развития современной науки. Раздвигая традиционные рамки «точных наук», этот процесс вовлекает сегодня в свою сферу биологию и социологию, языкознание и психологию, юриспруденцию и историю. Применение математических методов открывает во всех этих областях знаний пути для более глубокого проникновения в сущность и закономерности изучаемых явлений, более точного предсказания их развития в различных условиях, а значит, и более эффективного управления ими, практического их использования

Модель Колмогорова, связанная с педагогикой

Несмотря

на потребность

в применении математических методов в

педагогике, специалисты

в области

математики

отмечают,

что применение математических методов

в социальных и

гуманитарных

науках

связано с большими трудностями, так

как

выделение однородного

качества и его математическое изучение

затруднены тем, что

при этом

приходится учитывать и такие субъективные

факторы,

как

воля, цели, ценностные

ориентировки

и

мотивации

людей. Основная трудность

в этом

случае состоит

в построении

качественной

теории

процессов. Если не учитывать

этого,

возникает

опасность бесплодного увлечения

формулами и

математическим

аппаратом,

за которыми исследователи перестают

видеть

реальное

содержание изучаемых процессов.

Фактически

речь

идет об опасности узкого подхода к

сложнейшим, многофакторным

явлениям

социального, а следовательно, и

педагогического порядка. На

необходимость применять

методы

точных

наук с учетом специфики объектов такого

применения

указывают многие крупные учёные.

Основная трудность

в этом

случае состоит

в построении

качественной

теории

процессов. Если не учитывать

этого,

возникает

опасность бесплодного увлечения

формулами и

математическим

аппаратом,

за которыми исследователи перестают

видеть

реальное

содержание изучаемых процессов.

Фактически

речь

идет об опасности узкого подхода к

сложнейшим, многофакторным

явлениям

социального, а следовательно, и

педагогического порядка. На

необходимость применять

методы

точных

наук с учетом специфики объектов такого

применения

указывают многие крупные учёные.

Таким образом, можно утверждать, что применение математических методов в педагогикеограничено спецификой гуманитарной сферы. Тем не менее Л. Н. Колмогоров не отрицает возможности применения математических методов в науках, изначально достаточно далеких от математики, в том числе и гуманитарных.

Одним

из

важных математических методов являетсяматематическое моделирование.

Математические модели представляют

собой многофункциональноедидактическое

средство,

способствующее решению разнообразных

педагогических

задач. Возможности

этого средства остаются до сих пор

недостаточно раскрытыми.

Несмотря

на то, что такие модели являются формальным

инструментарием

познания, его

использование способствует достижению

не толькообразовательных,

но и развивающих

дидактических целей. Эго объясняетсятем,

что модели, неразрывно связанные

с конкретным содержанием учебного

предмета,помогаютего

представить

ярко, выпукло, соединив строгость научныхрассуждений

с глубоким научным анализом

структур изучаемых процессов и явленийлюбой

качественной природы.

Рассмотрим пример применения математических

моделейк

процессу обучения

в группе.

Возможности

этого средства остаются до сих пор

недостаточно раскрытыми.

Несмотря

на то, что такие модели являются формальным

инструментарием

познания, его

использование способствует достижению

не толькообразовательных,

но и развивающих

дидактических целей. Эго объясняетсятем,

что модели, неразрывно связанные

с конкретным содержанием учебного

предмета,помогаютего

представить

ярко, выпукло, соединив строгость научныхрассуждений

с глубоким научным анализом

структур изучаемых процессов и явленийлюбой

качественной природы.

Рассмотрим пример применения математических

моделейк

процессу обучения

в группе.

Математическое образование в учебных заведениях связано, преждевсего, с обучением в группе. Необходимой предпосылкой эффективности групповогообучения является адекватный подбор последовательности (траектории) изученияэлементов знания из учебного пособия в соответствии с поставленными целями.

Обучение

в группе

допускает различные стратегии.

Одна изних,

например, предполагает изучение

всех элементов знания за исключением

знанийусвоенных

каждым учеником группы. При такой стратегии практически каждомуученику

преходится затрачивать время

на повторное изучение уже известных

емуэлементов

знания.Другая

стратегия

группового обучения предполагает

изучениенового

материала,ориентируясь

на

«средний» уровень знаний учащихся

группы. Вторая стратегияобучения

в большей

степени учитывает начальную подготовку

учащихся, во требуетразработки

ни

диви дуальных траекторий выравнивания

знаний каждого из учеников.

При такой стратегии практически каждомуученику

преходится затрачивать время

на повторное изучение уже известных

емуэлементов

знания.Другая

стратегия

группового обучения предполагает

изучениенового

материала,ориентируясь

на

«средний» уровень знаний учащихся

группы. Вторая стратегияобучения

в большей

степени учитывает начальную подготовку

учащихся, во требуетразработки

ни

диви дуальных траекторий выравнивания

знаний каждого из учеников.

ПримерПустьGUI,OU2,…,GUk- графы, представляющие модели знанийучеников Ul,U2,…,Uk; ОС -модель цели обучения;NZ- набор задач. Опишемалгоритм построения ориентированной на первую стратегию обучения моделизнаний труппыUgучащихся:

окрасить вершины и дуги графаQ=GCв черный цвет;

все вершины и ребра графаG, входящие в модель знаний каждого ученика Ug, окрасить в зеленыйцвет.

Полученный таким образом цветной граф

называется моделью знаний группы Ug,

учащихся,

ассоциированнойс

цельюобучения

GC.

Второй алгоритм построения модели знаний группы ориентирован на вторую стратегию обучения. При такой стратегии материал, усвоенный большей частью группы, изучается только учащимися плохо знакомыми с данным материалом:

окрасить вершины и дуги графа G=GCв черный цвет;

все вершины и ребра графа G, входящие в половину и более моделей знаний учениковGUi(i= 1,.., к), окрасить в синий цвет;

все вершины и ребра графа G, входящие в каждую из моделей знаний учениковGUi, гдеi=I,к,окрасить в зеленый цвет.

Получим цветной граф GUg, который называется ассоциированной с целью обученияGCмоделью знаний группыUg учащихся и обозначаетсяM3r(Ug).

Ликвидация пробелов в знаниях учащихся производится по индивидуальной траектории выравнивания для каждого из учащихся.

Программные средства для моделирования предметно-коммуникативных сред (предметной области)

В настоящее время имеется большой набор

компьютерных проектных сред, предназначенных

для использования в учебном процессе. Одним из таких примеров IpSMRCflпакет «Живая геометрия». Он предназначен

для построения и изучения основных

геометрических объектов и их характеристик.

Это электронный аналог готовальни,

позволяющий создавать интерактивные

чертежи, а также выполнять различные

измерения. Программа позволяет

организовать деятельность учащихся по

построению моделей геометрических

объектов и исследованию их свойств.

Подобные пакеты могут использоваться

на уроках: либо учениками – в качестве

средства решения задач, либо учителем

— в качестве средства предоставления

учебной задачи путем оформления

определенного сценария, позволяющего

организовать демонстрацию задачи и ее

решения, вызов справочной информации

и т. п.

Одним из таких примеров IpSMRCflпакет «Живая геометрия». Он предназначен

для построения и изучения основных

геометрических объектов и их характеристик.

Это электронный аналог готовальни,

позволяющий создавать интерактивные

чертежи, а также выполнять различные

измерения. Программа позволяет

организовать деятельность учащихся по

построению моделей геометрических

объектов и исследованию их свойств.

Подобные пакеты могут использоваться

на уроках: либо учениками – в качестве

средства решения задач, либо учителем

— в качестве средства предоставления

учебной задачи путем оформления

определенного сценария, позволяющего

организовать демонстрацию задачи и ее

решения, вызов справочной информации

и т. п.

Пакет

«Живая физика»

— это компьютерная проектная среда, с

помощьюкоторой

можно

организовать

деятельность по моделированию объектов,

процессов иявлений.

Набор

объектов,

законы, формулы и т. п. уже заданы.

Пользовательвыбирает

ит

предоставляемого

набора какой-либо объект, устанавливает

егопараметры,

святи

с другимиобъектами

и внешние

условия проведения эксперимента. Естьвозможность

использования

виртуальных измерительных инструментов

ивыбора

способа

представления

результатов: мультипликация, график,

таблица,вектор.

.пакет может

быть востребован при изучении школьного

курсафизики

или в старших

классах науроках

математики

или информатики прирассмотрении

тем, связанных

с компьютерным

моделированием. Он призван помочьучащимся

понять теорию, научиться

решать задачи,

самостоятельно организоватьи

провести эксперименты.

Естьвозможность

использования

виртуальных измерительных инструментов

ивыбора

способа

представления

результатов: мультипликация, график,

таблица,вектор.

.пакет может

быть востребован при изучении школьного

курсафизики

или в старших

классах науроках

математики

или информатики прирассмотрении

тем, связанных

с компьютерным

моделированием. Он призван помочьучащимся

понять теорию, научиться

решать задачи,

самостоятельно организоватьи

провести эксперименты.

Специфика использования компьютерного моделировании в педагогических программных средствах

Важную часть информационной среды школы составляет правильно подобранный набор программного обеспечения, в состав ко торого могу т входить:

– программные средства общего назначения для работы со всеми видами информации;

I источники информации в форме электронных энциклопедий и коллекций текстов, изображений, видео и т. д.;

виртуальные лаборатории/конструкторы, позволяющие создавать наглядные н символические имитационные модели математической, физической и биологической реальности и проводить эксперименты о этими моделями;

■ интегрированные

творческие среды, включающие в себя

редакторы тек- рщрфики, музыки и набор

программируемых объектов.

Важнейшая задача современной школы – гармоническое развитие личности, которое основывается на прочных знаниях, овладении определенными навыками и умение применять их на практике.Мастерство учителя основано на умении строить процесс обучения в соответствии сзакономерностями этою процесса, одним из которых является принцип наглядности.Использование наглядности в обучении имеет как сторонников, так и противников. Это свидетельствует о нечетком понимании принципа наглядности, дополненногонедавно принципом моделирования. Вторым фактором, определяющим качествообучения, являютсяспособности учащихся. Чтобы расширить сферу чувственного познания и как-то воспринимать объекты, непосредственно чувственно не воспринимаемые, разрабатываются особые методы и средства. Эго разного рода приборы, усиливающие органы чувств (на* пример – телескоп X приборы для восприятия объектов прошлого (фотоаппарат) шт объекты, находящиеся в замкнутом пространстве и далеко (телевидение).

Если говорить о программных средствах

для построения компьютерных моделей,

то все авторы рекомендуют использовать

наиболее популярное средство компьютерного

моделирования – электронные таблицы. СУБД не задумывалось как средство

моделирования, но создание информационных

моделей объектов с возможностью проводить

при помощи таких моделей выборку

информации, удовлетворяющей каким-либо

условиям с целью дальнейшего анализа

этого объекта, позволяет проводить

моделирование с помощью баз данных,

СУБД не задумывалось как средство

моделирования, но создание информационных

моделей объектов с возможностью проводить

при помощи таких моделей выборку

информации, удовлетворяющей каким-либо

условиям с целью дальнейшего анализа

этого объекта, позволяет проводить

моделирование с помощью баз данных,

Алгоритмические языки

программировании

издавна используются для построения

моделей. Если

нет

возможности

использовать для построения моделей

другие средства, то спомощью

языков

программирования можно строить модели

из самых различных классовмоделей

(физические

и логические, геометрические и

экологические и т. п.). У А. Г. Кушнеренко

приводится пример построения модели

зрительного зала. Здеськомпьютерная

модель

зрительного зала – это программа

на

учебном

алгоритмическомязыке,

которая

затем должна быть реализована на языке

программирования. Для тогочтобы

ученик

в 9-м классе построил такую модель (в

ней множество встроенныхциклов)

необходимо,

чтобы он достаточно хорошоумел

программировать. Но,к

сожалению,

процент

девятиклассников, которые слегкостью

используют

встроенныециклы,

совсем

невелик.

Но,к

сожалению,

процент

девятиклассников, которые слегкостью

используют

встроенныециклы,

совсем

невелик.

Математические модели демографии – учебный курс

- Автор: Лебедев А.В.

- Год создания: 2003

- Организация: МГУ имени М.В. Ломоносова

- Описание: Курс (полугодовой) обязательный для студентов 5 курса экономического потока. Излагаются математические модели демографии, как классические, так и современные. Автором выпущены учебные пособия по курсу, последнее в 2017 году (см. https://istina.msu.ru/publications/book/51434817/ ) Программа курса регулярно обновляется, последнее обновление – в 2019 году. С весны 2020 года читается также магистрам 1-го года МШЭ МГУ по программе “Экономика и математические методы”.

- Добавил в систему: Лебедев Алексей Викторович

Прикрепленные файлы

| № | Имя | Описание | Имя файла | Размер | Добавлен |

|---|---|---|---|---|---|

1. | Руководства по темам курса (для дистанционного обучения) | MD-2020.ZIP | 5,5 МБ | 24 августа 2020 [aleb] | |

| 2. | Теория ветвящихся случайных процессов (Т.Харрис) | Harris_T. _Sevastyanov_B.A.per._SHteinpress_L.BookFi.djvu _Sevastyanov_B.A.per._SHteinpress_L.BookFi.djvu | 5,1 МБ | 18 марта 2020 [aleb] | |

| 3. | Работы И.А.Алешковского | aleshkovski.zip | 871,1 КБ | 1 января 2021 [aleb] | |

4. | Сборник задач по математической демографии (А.В.Лебедев, 2017, с исправлениями 2022) | tekst_Lebedev_itog22.pdf | 2,5 МБ | 11 июля 2022 [aleb] | |

| 5. | Статья в “Техника-молодежи” (А.В.Лебедев, 2001) | DEMO. pdf pdf | 123,2 КБ | 15 февраля 2022 [aleb] | |

| 6. | Профстандарт Демограф | Prikaz_Ob_utverzhdenii_professionalnogo_standarta_Demogra… | 1,1 МБ | 11 июля 2022 [aleb] | |

7. | Краткая история математической динамики населения (Н.Бакаэр) | ru.pdf | 1,2 МБ | 6 августа 2021 [aleb] | |

| 8. | Рабочая программа курса (2019) | RP-MMD-2019.pdf | 172,3 КБ | 13 августа 2019 [aleb] | |

9. | Азы математической демографии (Староверов О.В.) | Staroverov_O.V._Azue_matematicheskoi_demografiiBookFi.org… | 2,4 МБ | 31 августа 2019 [aleb] | |

| 10. | Изучение продолжительности жизни (сборник) | demogr08. pdf pdf | 10,7 МБ | 31 августа 2019 [aleb] | |

| 11. | Интересные ссылки по демографии | Demografiya-ssyilki-2019.pdf | 69,6 КБ | 31 августа 2019 [aleb] |

Преподавание курса

- 7 февраля 2022 – 31 мая 2022 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Московская школа экономики

В. Ломоносова, Московская школа экономики - обязательная, вариативной части, лекции, 28 часов

- Автор: Лебедев А.В.

- 1 сентября 2021 – 31 декабря 2021 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

- обязательная, вариативной части, лекции, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2021 – 31 декабря 2021 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей - обязательная, вариативной части, семинары, 36 часов

- Автор: Лебедев А.В.

- 8 февраля 2021 – 31 мая 2021 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Московская школа экономики

- обязательная, вариативной части, лекции, 28 часов

- Автор: Лебедев А.В.

- 1 сентября 2020 – 31 декабря 2020 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей - обязательная, вариативной части, семинары, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2020 – 31 декабря 2020 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

- обязательная, вариативной части, лекции, 36 часов

- Автор: Лебедев А.В.

- 7 февраля 2020 – 31 мая 2020 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Московская школа экономики

В. Ломоносова, Московская школа экономики - обязательная, вариативной части, лекции, 28 часов

- Автор: Лебедев А.В.

- 2 сентября 2019 – 31 декабря 2019 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

- обязательная, вариативной части, лекции, 36 часов

- Автор: Лебедев А.В.

- 2 сентября 2019 – 31 декабря 2019 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей - обязательная, вариативной части, семинары, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2018 – 31 декабря 2018 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

- обязательная, вариативной части, семинары, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2018 – 31 декабря 2018 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей - обязательная, вариативной части, лекции, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2017 – 31 декабря 2017 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

- обязательная, вариативной части, лекции, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2017 – 31 декабря 2017 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей - обязательная, вариативной части, семинары, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2016 – 30 декабря 2016 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

- обязательная, вариативной части, лекции, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2016 – 30 декабря 2016 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей - обязательная, вариативной части, семинары, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2015 – 30 декабря 2015 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

- обязательная, вариативной части, лекции, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2015 – 30 декабря 2015 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей - обязательная, вариативной части, семинары, 18 часов

- Автор: Лебедев А.В.

- 1 сентября 2014 – 31 декабря 2014 Голдаева Анна Алексеевна

- МГУ имени М.В. Ломоносова, Механико-математический факультет

- обязательная, базовой части, лекции, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2014 – 31 декабря 2014 Голдаева Анна Алексеевна

- МГУ имени М.

В. Ломоносова, Механико-математический факультет

В. Ломоносова, Механико-математический факультет - обязательная, базовой части, семинары, 18 часов

- Автор: Лебедев А.В.

- 1 сентября 2013 – 31 декабря 2013 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

- обязательная, вариативной части, лекции, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2013 – 31 декабря 2013 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей - обязательная, вариативной части, семинары, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2012 – 31 декабря 2012 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

- обязательная, вариативной части, семинары, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2012 – 31 декабря 2012 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей - обязательная, вариативной части, лекции, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2011 – 31 декабря 2011 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

- обязательная, вариативной части, лекции, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2011 – 31 декабря 2011 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей - обязательная, вариативной части, семинары, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2010 – 31 декабря 2010 Лебедев Алексей Викторович

- МГУ имени М.В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

- обязательная, вариативной части, лекции, 36 часов

- Автор: Лебедев А.В.

- 1 сентября 2010 – 31 декабря 2010 Лебедев Алексей Викторович

- МГУ имени М.

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей

В. Ломоносова, Механико-математический факультет, Отделение математики, Кафедра теории вероятностей - обязательная, вариативной части, семинары, 36 часов

- Автор: Лебедев А.В.

Педагогический дизайн: задачи, этапы и модели

Педагогический дизайн (Instructional design, ID) — относительно новое понятие в современной системе образования. Потребность в формировании качественных знаний постоянно растет, в то время как традиционные инструменты подходят для относительно простых, «линейных» методов подготовки.

При создании более сложных программ применение традиционных методов ведет к потерям времени и ресурсов. В итоге появилось понятие педагогического дизайна — дисциплины, которую команды разработчиков применяют еще на стадии проектирования, создания и оценки обучающих материалов. В его основу положено систематическое использование знаний об эффективной работе, выстраивании учебного процесса с «открытой архитектурой» и создании настоящей обучающей среды.

Задачи педагогического дизайнера

Технология педагогического дизайна относительно проста. Нужно понять потребности учащихся и определить цели обучения, а затем передать знания и информацию максимально быстро, точно и эффективно. Но для этого требуется понять все предпосылки и четко задать конечные свойства продукта. А это, в свою очередь, требует планомерной и хорошо выстроенной работы, причем не одного человека, а грамотно подобранной команды разработчиков. При этом задачи педагогического дизайнера обширны и весьма непросты:

- Анализ потребностей целевой аудитории, её компетенций и ожидаемых результатов обучения.

- Определение целей и задач учебного материала.

- Анализ и структурирование материалов в соответствии с целями.

- Выбор средств и методов учебной работы.

- Создание элементов, стиля и визуального дизайна курса.

- Разработка тестов и заданий, средств контроля и сбора информации.

- Создание курса с помощью соответствующих инструментов, либо постановка задач членам команды для разработки конкретных элементов.

- Загрузка курса в систему управления обучением (Learning Management System, LMS).

- Разработка методов оценки результатов и эффективности материалов.

- Выработка решения для дальнейшего совершенствования учебного контента.

Такая четкая последовательность обеспечит качественный рост учебного материала по мере выполнения работы и отточит формы его подачи.

Принципы педагогического дизайна

Основная задача качественной и планомерной разработки учебного курса — максимально полная передача нужной информации в доступной для ученика форме. Важен не просто сам факт её предоставления — с этим неплохо справляются более простые методы. Главной задачей является именно четкое восприятие и последующее применение полученных знаний на практике. Для достижения этого в основы педагогического дизайна заложены 8 принципов американского психолога Роберта Ганье (Robert Mills Gagne), одного из основателей педагогического дизайна и автора книг по теории обучения.

- Привлечение внимания учеников, мотивация на обучение, пробуждение интереса к теме и методам.

- Объяснение целей и задач обучения. Здесь не только даётся ответ на вопрос «зачем?», но и формируется определенный уровень ожиданий от итогов самого процесса.

- Представление нового материала. Наиболее сложная часть процесса, поскольку выборочность восприятия любого нового материала свойственна человеческой психике. А это значит, что необходимо заранее предусмотреть определенные элементы, которые позволят удержать внимание ученика на важных моментах и довести до него главную мысль проекта в максимально доступной форме.

- Сопровождение обучения. По сути это руководство учениками и семантическое формирование установки на удержание полученного материала в долгосрочной памяти.

- Практика. Необходимо быстро, пока новые знания еще свежи, опробовать их в реальных условиях или просто подтвердить соответствующим экспериментом, что четко и весьма эффективно увяжет теорию и приложение знаний.

- Обратная связь.

Оценка выбранного метода обучения и его эффективности невозможна без оперативного анализа. Поэтому еще на этапе разработки курса должна закладываться максимально гибкая система обратной связи (здесь пригодятся результаты анализа целевой аудитории и её возможностей).

Оценка выбранного метода обучения и его эффективности невозможна без оперативного анализа. Поэтому еще на этапе разработки курса должна закладываться максимально гибкая система обратной связи (здесь пригодятся результаты анализа целевой аудитории и её возможностей). - Оценка успеваемости и общая оценка эффективности учебного курса.

- Перевод в практическую плоскость, помощь ученикам в сохранении знаний и их правильном применении.В отличие от пятого принципа, здесь важно перенести практические навыки в новые условия, не заданные изначальными рамками курса. Это позволит оценить глубину усвоения знаний.

5 этапов разработки учебных материалов

Процесс проектирования учебных материалов по многим параметрам схож с такими дисциплинами как программирование, логистика, дизайн и прикладная психология. Это последовательность четко определенных процедур, которые сгруппированы в ряд этапов и имеют конкретные задачи и методы их решения. Чаще всего при разработке педагогического дизайна урока используется хорошо зарекомендовавшая себя модель ADDIE (Analysis, Design, Development, Implementation, Evaluation), разбивающая весь процесс на 5 этапов.

Чаще всего при разработке педагогического дизайна урока используется хорошо зарекомендовавшая себя модель ADDIE (Analysis, Design, Development, Implementation, Evaluation), разбивающая весь процесс на 5 этапов.

1. Анализ

Самая важная стадия разработки: выделяются ключевые элементы, изучаются потребности учеников и задача учителя, формулируются измеримые и понятные цели обучения, оценивается целевая аудитория и формы работы с ней, а также составляется список ожидаемых результатов. Для повышения эффективности эта стадия также разбивается на несколько этапов, позволяющих за счет постепенного выявления ключевых точек четко сформулировать задачи. Тщательно проработанные цели помогают определить инструментарий учебного курса, степень его наполнения интерактивными элементами и применимость уже имеющихся материалов и методик.

Здесь же можно четко определить методики оценки эффективности самого процесса обучения. Явно и точно заданные ожидаемые результаты позволят четко сформулировать содержание и форму упражнений, контрольных вопросов, итоговых заданий и формы их подачи. А также дадут возможность сравнить между собой материалы и методики различных авторов, выбрав только максимально подходящие. Это поможет и самому ученику в процессе обучения, сконцентрирует внимание на сути предлагаемого материала и направит усилия на достижение целей.

А также дадут возможность сравнить между собой материалы и методики различных авторов, выбрав только максимально подходящие. Это поможет и самому ученику в процессе обучения, сконцентрирует внимание на сути предлагаемого материала и направит усилия на достижение целей.

После того как выполнен анализ, цели обучения можно уточнить, что даст возможность приступить к разработке собственно учебных материалов.

2. Проектирование

Самая обширная и непредсказуемая стадия проекта. В этот момент необходимо учесть все выводы стадии анализа и выработать общий план и структуру материала, оформить схему упражнений и оценок, визуальный ряд, интерфейс и общий дизайн, увязать между собой десятки порой сильно различающихся компонентов. По сути создается некий прототип, сценарий всего проекта, определяющий влияние каждого элемента на задачи, выявленные на первом этапе. Он также должен быть разбит на несколько шагов, поскольку попытка решить все задачи без планомерного подхода чаще всего обречена на провал.

- Выбор средств обучения. Здесь все также начинается с анализа и изучения целевой аудитории, ожидаемых условий и форм обучения, содержания материалов и применимости к ним тех или иных методов демонстрации. Затем можно приступать к детализации учебных задач и уточнению инструментария, а также выявлению необходимых знаний, умений и навыков, позволяющих выполнить все задачи курса.

- Создание сценария или план-схемы будущих учебных материалов, оформление и утверждение внешнего вида типовых экранов, проработка рабочих макетов разных фрагментов и экспертная оценка каждого элемента. Главное на этом этапе — уточнение технических требований к будущему курсу.

- Подготовка пробной версии учебных материалов, подбор или создание иллюстраций, анимационных эффектов и интерактивных элементов, аудио- или видеоряда. На этом этапе можно выявить отдельные недочеты, быстро исправить их и оперативно внести изменения в рабочий сценарий.

- Оценка и доработка материалов с точки зрения полного соответствия задачам.

Здесь максимально эффективны сторонняя экспертиза и все виды моделирования: от педагогического эксперимента с обучением тестовой группы до мозгового штурма по выявлению сильных и слабых сторон разработанного продукта.

Здесь максимально эффективны сторонняя экспертиза и все виды моделирования: от педагогического эксперимента с обучением тестовой группы до мозгового штурма по выявлению сильных и слабых сторон разработанного продукта. - Сопровождение и развитие учебных материалов. На этом шаге уже можно сосредоточиться на решении мелких технических вопросов, возникающих по ходу создания и тестирования, дополнять и расширять удачные модули, выявлять логические связки, готовить выход новых версий или создавать новые учебные курсы с использованием имеющихся наработок.

3. Разработка

Основная «техническая» стадия любого проекта, когда все созданные материалы занимают свое место в общей структуре, обрастают новыми элементами и логическими связями, проходят отладку и «притирку» между собой. Здесь же можно очень тонко настроить выбор методов изложения материала, тона подачи, стиля, форму изложения отдельных элементов исходя из целей всего проекта и особенностей аудитории.

На этом этапе окончательно встраиваются элементы общего контента, подбираются наиболее эффективные упражнения, вырабатываются формы обратной связи и проверки освоения материала (задания и способы контроля), оттачиваются интерфейс и связки (правила перехода) между отдельными темами или вопросами. Особое внимание следует уделить четкому определению инструментария для подведения итогов проверки или практической работы, что позволит оценить эффективность всего курса. Этап разработки — это очень кропотливая, но творческая работа, требующая от создателей максимальной гибкости при выполнении жестких исходных установок.

4. Реализация

На этой стадии учебный курс загружается в в соответствующую систему управления обучением (Learning Management System, LMS) или на ресурс, с помощью которого ученики могут получить доступ к материалам. Несмотря на казалось бы малую значимость этой стадии, она позволяет оценить применимость учебных материалов на практике. Именно здесь можно проверить, подходит ли урок или курс для выбранной аудитории, получить первичные данные о его выполнении и эффективности, наладить связь с сообществом обучающихся, что даст дополнительный материал для подготовки инструкций, сопроводительных документов и так далее.

5. Оценка

После накопления первичной информации о выполнении учебного курса нужно оценить его эффективность. Необходимо соотнести поставленные на стадии анализа задачи с результатами, которые получены на практике. Оцениваются сами учебные материалы, достижение целей обучения, выполнимость того или иного типа заданий и их соответствие общей задаче. На основании этого дорабатывается курс в целом или отдельные уроки, оцениваются результаты учебной работы и намечаются пути корректировки учебных материалов. Эта стадия в идеале должна закончиться пересмотром требований к отдельным блокам и обновленной версией всего курса.

Другие модели педагогического дизайна

ADDIE

ADDIE в настоящее время считается практически стандартом разработки учебных курсов с использованием правил педагогического дизайна. Её логичность и хорошо просматриваемая связь с классическими методами дает массу преимуществ. Есть и другие методики, вроде SAM, ALD, Dick & Carey Systems Approach Model или Jerrold Kemp Instructional Design Model, но пока они используются менее интенсивно.

Появление новых подходов легко объяснимо — растет объем информации, что увеличивает сложность линейного планирования, происходит смещение интереса разработчиков и потребителей. Поэтому подходы, ориентированные на явно заданные цели, все чаще уступают место конструктивистским моделям обучения. Это позволяет упростить процедуры педагогического дизайна и включить в них элементы кооперации и рефлексии, технологии быстрого прототипирования, каскадную модель и прочие методики. Процедура анализа, например, может длиться на протяжении всей разработки. Подготовка проектной документации сливается с фазой разработки материала. Даже доводка продукции вполне допустима на стадии окончательно работоспособной версии, «на площадке пользователя», что очень похоже на современные методики создания компьютерных программ с их бесконечными патчами и релизами.

Таким образом, жесткая последовательная цепочка производственных этапов превращается в единый процесс со множеством итераций. Грань между проектированием и производством материалов постепенно стирается, а сами они начинают взаимодействовать между собой по гораздо большему количеству смысловых или логических связок. Это дает разработчикам возможность создания весьма сложных комплексов учебных материалов.

Это дает разработчикам возможность создания весьма сложных комплексов учебных материалов.

SAM

Один из ярких примеров — модель SAM (Successive Approximation Model, Последовательная модель приближения). Её суть не в планомерном линейном развитии проекта, а в сочетании выполнения небольших по содержимому, по постоянно повторяющихся циклов разработки. Каждый из них постепенно приближает к выполнению общей задачи за счет все большей концентрации усилий по мере прохождения циклов. Это позволяет создать даже очень масштабные проекты «малыми шагами», разрабатывая каждый компонент максимально быстро и просто, поэтапно нарабатывая элементы взаимной привязки в процессе. Однако и здесь обязательно используется логичная цепочка развития, а весь процесс делится на четыре основные стадии:

- Подготовка (Preparation) — сбор информации и создание первичной базы данных по всему объему материала, который будет изучаться посредством итогового продукта.

Подразумевается, что эта стадия должна быть очень быстрой, хотя на практике это далеко не так.

Подразумевается, что эта стадия должна быть очень быстрой, хотя на практике это далеко не так. - Цикличная разработка (Iterative Design) — по сути мозговой штурм всех участников проекта, позволяющий быстро наработать сначала основу, а затем за счет создания все новых и новых логических блоков нарастить общий объем материала.

- Цикличное развитие (Iterative Development) — постоянное расширение материала за счет новых блоков, встраивание его в общую структуру и оценка полученных результатов.

- Карта действия (Action Mapping) — быстрый и эффективный визуальный способ проектирования. По сути это моделирование действий человека в процессе обучения, изучающее его действия в незнакомой среде. Её главными инструментами являются поиск наилучшего пути решения проблемы, создание стимулирующих, а не информационных материалов, включение в процесс изучения интуиции и экспертная оценка итогов. Проектировщик не создает «карту» самостоятельно, с самого начала над ней работают и обучающийся (пока еще в рамках модели), и эксперт.

Поэтому на данном этапе также необходим тщательный анализ, как и во время предварительной проработки проекта.

Поэтому на данном этапе также необходим тщательный анализ, как и во время предварительной проработки проекта.

Такая методика явно ориентирована не на академическую среду, а на профессионально-техническое образование и корпоративный сегмент, где относительно легко установить измеримую цель и проанализировать степень её достижения. Процесс сосредотачивается именно на конкретных навыках, а не на общем объеме знаний, что предъявляет повышенные требования к практическому опыту самих разработчиков. Все элементы итогового продукта должны строго оправдывать свое существование, выполняя непосредственно поставленные задачи и отсекая все лишнее. В этом наблюдается явное сходство с методологией SMART.

SMART

SMART – система проектного управления, базирующаяся на четко сформулированных и измеримых целях. Её суть заложена в самом названии — Specific (Конкретный), Measurable (Измеримый), Attainable (Достижимый), Relevant (Актуальный) и Time-bound (Ограниченный во времени), вместе — SMART (Умный). То есть цель непременно должна быть конкретной, измеримой, достижимой, значимой и соотноситься с конкретным сроком. А скорость и эффективность выполнения задачи зависит от правильной её формулировки. Причем каким образом будет достигнуто выполнение, не имеет особого значения. Это может быть и поэтапное и планомерное повышение результатов за счёт множества небольших шагов, и сразу ориентация на максимально возможный результат — главное, чтобы он был конкретно и объективно измерим. Предварительный анализ и планирование путей здесь также играют колоссальную роль, поэтому эта концепция применима и к педагогическому дизайну в целом.

То есть цель непременно должна быть конкретной, измеримой, достижимой, значимой и соотноситься с конкретным сроком. А скорость и эффективность выполнения задачи зависит от правильной её формулировки. Причем каким образом будет достигнуто выполнение, не имеет особого значения. Это может быть и поэтапное и планомерное повышение результатов за счёт множества небольших шагов, и сразу ориентация на максимально возможный результат — главное, чтобы он был конкретно и объективно измерим. Предварительный анализ и планирование путей здесь также играют колоссальную роль, поэтому эта концепция применима и к педагогическому дизайну в целом.

ALD

Методика ALD (Agile Learning Design) делает акцент на скорости, гибкости и кооперативности разработки. Она вобрала в себя множество наработок из области создания программного обеспечения, главный её козырь — ускорение повышения квалификации за счет резкого увеличения концентрации на специфических задачах. Поэтому она всё чаще находит свое место в создании систем дистанционного обучения и переподготовки, где необходима интенсивная передача материала и использование активного интереса самого обучающегося.

Основные принципы методики ALD:

- Диалоговая подача материала с постоянной повторной проработкой ключевых моментов для закрепления.

- Применение шаблонов и других стандартных инструментов для быстрого и эффективного выполнения задачи.

- Активное использование интереса обучающегося и его стимулирование.

- Приоритет подачи ключевых моментов над второстепенными.

- Активное привлечение экспертов в узких областях знаний.

- Создание интерактивных баз данных со всем справочным материалом как по самой теме, так и по близким дисциплинам.

- Концентрация на самом процессе обучения и материале, а не на планировании.

- Систематическая оценка процесса обучения и потребностей ученика на каждом этапе.

В итоге создание и использование учебных материалов приобретает еще более конкретный вид, а лишние на данном этапе массивы знаний отсеиваются. Однако это вовсе не означат примитивизации процесса — в любое время все необходимые данные могут быть использованы по назначению. Причем как по мере готовности ученика, так и при появлении новых задач, что придает системе ALD большую гибкость при высокой концентрации на процессе.

Причем как по мере готовности ученика, так и при появлении новых задач, что придает системе ALD большую гибкость при высокой концентрации на процессе.

Заключение

Споры об эффективности методик можно вести бесконечно. Однако хорошо заметно, что каждая из них имеет четкую ориентацию на конкретный сегмент, а потому все сильные и слабые стороны жестко связаны с самой потребностью выстраивать обучение различных групп с учетом их специфических потребностей. Хорошо освоенная и проработанная методика ADDIE даст мощный инструментарий для создания универсальных обучающих курсов, ориентированных по получение фундаментальных знаний, но требует очень высокой квалификации разработчиков. SAM позволяет объективно ускорить и упростить процесс разработки, а также придать ему большую гибкость в случае появления новых задач. А технологии ALD дают возможность быстро и четко создавать узкоспециализированные курсы, ориентированные на специальные области знаний.

Если вам понравилась статья, дайте нам знать — нажмите кнопку Поделиться.

А если у вас есть идеи для полезных статей на тему электронного обучения — напишите нам в комментариях, и мы будем рады поработать над новым материалом. 14-дневная пробная версия

учебные стоматологические модели для обучения стоматологов // Смотрим

26 июля 2022, 08:30

Хотите принять участие в программе? Достаточно заполнить форму

- общество

- музыка

- шоу

- публицистика

- искусство

- радио

- Сергей Стиллавин

- история

- медицина

- тест-драйв

- радиопередача

- путешествия

- Радио Маяк

- История (Радио Маяк)

- Музыка (Радио Маяк)

- Популярные шоу (Радио Маяк)

- Жизнь (Радио “Маяк”)

- В эфире (Радио “Маяк”)

Смотрим всё

Что такое обучение модели | Oden Technologies

Индустрия 4.

0 Глоссарий

0 Глоссарий- 01Что такое обучение модели?

- 02Что такое обучение модели в машинном обучении

- 03Создание модели в машинном обучении

- 04Сколько времени занимает обучение модели машинного обучения?

Модель обучения машинного обучения — это процесс, в котором алгоритм машинного обучения (МО) получает достаточно обучающих данных для обучения.

Модели машинного обучения могут быть обучены для использования в производственных процессах несколькими способами. Способность моделей машинного обучения обрабатывать большие объемы данных может помочь производителям выявлять аномалии и тестировать корреляции при поиске закономерностей в потоке данных. Он может предоставить производителям возможности профилактического обслуживания и свести к минимуму запланированные и незапланированные простои.

Что такое обучение модели в машинном обучении?

Модель обучения — это набор данных, который используется для обучения алгоритма машинного обучения. Он состоит из выборочных выходных данных и соответствующих наборов входных данных, влияющих на результат. Модель обучения используется для пропуска входных данных через алгоритм, чтобы сопоставить обработанный вывод с образцом вывода. Результат этой корреляции используется для модификации модели.

Он состоит из выборочных выходных данных и соответствующих наборов входных данных, влияющих на результат. Модель обучения используется для пропуска входных данных через алгоритм, чтобы сопоставить обработанный вывод с образцом вывода. Результат этой корреляции используется для модификации модели.

Этот повторяющийся процесс называется «подгонка модели». Точность набора обучающих данных или набора данных проверки имеет решающее значение для точности модели.

Обучение модели на машинном языке — это процесс подачи в алгоритм машинного обучения данных, помогающих идентифицировать и изучать правильные значения всех задействованных атрибутов. Существует несколько типов моделей машинного обучения, наиболее распространенными из которых являются контролируемое и неконтролируемое обучение.

Обучение с учителем возможно, когда обучающие данные содержат как входные, так и выходные значения. Каждый набор данных, который имеет входы и ожидаемый результат, называется контрольным сигналом. Обучение выполняется на основе отклонения обработанного результата от задокументированного результата при подаче входных данных в модель.

Обучение выполняется на основе отклонения обработанного результата от задокументированного результата при подаче входных данных в модель.

Неконтролируемое обучение включает определение закономерностей в данных. Дополнительные данные затем используются для подбора шаблонов или кластеров. Это также итеративный процесс, который повышает точность на основе корреляции с ожидаемыми шаблонами или кластерами. В этом методе нет эталонного набора выходных данных.

Создание модели в машинном обучении

Создание модели машинного обучения состоит из 7 основных шагов. Вот краткий обзор каждого из этих шагов:

Определение проблемы

Определение постановки задачи — это первый шаг к определению того, чего должна достичь модель ML. Этот шаг также позволяет распознавать соответствующие входы и соответствующие им выходы; Такие вопросы, как «какова основная цель?», «какие входные данные?» и «что модель пытается предсказать?» необходимо ответить на этом этапе.

Сбор данных

После определения постановки задачи необходимо исследовать и собрать данные, которые можно использовать для питания машины. Это важный этап в процессе создания модели машинного обучения, поскольку количество и качество используемых данных будут определять, насколько эффективной будет модель. Данные можно собирать из уже существующих баз данных или создавать с нуля

Подготовка данных

Этап подготовки данных состоит в том, что данные профилируются, форматируются и структурируются по мере необходимости, чтобы подготовить их для обучения модели. На этом этапе выбираются соответствующие характеристики и атрибуты данных. Этот этап, вероятно, окажет прямое влияние на время выполнения и результаты. Это также на этапе, когда данные делятся на две группы: одна для обучения модели машинного обучения, а другая для оценки модели. На этом этапе также осуществляется предварительная обработка данных путем нормализации, устранения дубликатов и исправления ошибок.

Назначение подходящей модели/протоколов

Выбор и назначение модели или протокола должны выполняться в соответствии с целью, для достижения которой предназначена модель ML. Есть несколько моделей на выбор, таких как линейная регрессия, k-средних и байесовская. Выбор моделей во многом зависит от типа используемых данных. Например, сверточные нейронные сети для обработки изображений были бы идеальным выбором, а k-средние лучше всего работали бы для сегментации.

Обучение модели машины или «Обучение модели»

Это этап, на котором алгоритм машинного обучения обучается путем подачи наборов данных. Это этап, на котором происходит обучение. Последовательное обучение может значительно улучшить скорость прогнозирования модели ML. Веса модели должны быть инициализированы случайным образом. Таким образом, алгоритм научится соответствующим образом корректировать веса.

Оценка и определение критерия успеха

Модель машины должна быть протестирована на соответствие «проверочному набору данных». Это помогает оценить точность модели. Определение мер успеха на основе того, для чего предназначена модель, имеет решающее значение для обоснования корреляции.

Это помогает оценить точность модели. Определение мер успеха на основе того, для чего предназначена модель, имеет решающее значение для обоснования корреляции.

Настройка параметров

Выбор правильного параметра, который будет изменен для воздействия на модель машинного обучения, является ключом к достижению точной корреляции. Набор параметров, которые выбираются на основе их влияния на архитектуру модели, называются гиперпараметрами. Процесс определения гиперпараметров путем настройки модели называется настройкой параметров. Параметры корреляции должны быть четко определены таким образом, чтобы точка убывающей отдачи для проверки была как можно ближе к 100% точности.

Сколько времени занимает обучение модели машинного обучения?

Для обучения модели машинного обучения не существует определенного периода или предустановленного набора итераций. Факторами, влияющими на продолжительность обучения, могут быть качество обучающих данных, правильное определение мер успеха и сложность выбора модели. Такие факторы, как метод обучения, распределение весов и сложность модели, также играют важную роль. Другие факторы, не относящиеся к данным или моделям, такие как вычислительная мощность и квалифицированные ресурсы, также могут влиять на продолжительность обучения. Всегда есть возможность оптимизировать обучение модели, поскольку количество параметров, влияющих на ее продолжительность, слишком велико.

Такие факторы, как метод обучения, распределение весов и сложность модели, также играют важную роль. Другие факторы, не относящиеся к данным или моделям, такие как вычислительная мощность и квалифицированные ресурсы, также могут влиять на продолжительность обучения. Всегда есть возможность оптимизировать обучение модели, поскольку количество параметров, влияющих на ее продолжительность, слишком велико.

Корпоративные модели обучения в области обучения и развития — Модели обучения и развития

Джейн Харт, директор и редактор Центра современного обучения на рабочем месте, недавно написала статью об опросе, который она проводит по ценным способам обучения на рабочем месте. Ее результаты показывают, что формальные мероприятия, предлагаемые большинством организаций обучения и развития (например, электронное обучение, конференции, аудиторные занятия), на самом деле считаются наименее ценными для развития учащихся. Удивительно, правда? Фактически, в то время как отделы обучения и развития обычно сосредотачиваются на создании более привлекательных и интерактивных учебных курсов, Харт показывает, что на самом деле сотрудники хотят более актуальный, современный подход , включающий ежедневный рабочий опыт , обмен знаниями с командами , веб-ресурсы , профессиональные сети и сообщества , и отзывы наставников в программы.

Почему именно эти методы имеют более высокий рейтинг?

Как наиболее ценный метод обучения, ежедневный рабочий опыт имеет решающее значение для обучения сотрудников, поскольку он позволяет сотрудникам практиковать и применять полученные навыки в реальном мире, а также участвовать в непрерывном обучении, а не в эпизодическом обучении. Кроме того, личное ежедневное взаимодействие предоставляет возможности для социального обучения, которое помогает развивать все более важные социальные навыки на рабочем месте, такие как общение, лидерство и работа в команде.

Обмен знаниями в вашей команде расширяет возможности обучения, облегчая контекстно-зависимое обучение и обеспечивая более глубокое обучение. В конце концов, только сначала обдумав и переоценив свои мысли, люди могут затем воплотить их в жизнь и поделиться ими целостным и всеобъемлющим образом.

Аналогичным образом, получение обратной связи позволяет учащимся получить доступ к ценным знаниям не только от своих опытных наставников, но и от своих сверстников. Обратная связь со сверстниками может быть даже более действенной, чем обратная связь от экспертов, отчасти потому, что новые учащиеся могут лучше объяснять понятия другим учащимся, а отчасти потому, что социальные связи (в том числе профессиональные сети и сообщества ) привносят социальные связи и подкрепление в динамику обучения (узнайте, как оптимизировать обратную связь на онлайн-курсах). Кроме того, Харт указывает, что ключевой особенностью, которая делает этот конкретный аспект успешным, является то, что они выбираются и организуются самими работниками. Этот акт самоотбора и самоорганизации поощряет самодостаточность в непрерывном обучении, что является важным навыком, который необходимо развивать в контексте постоянно меняющегося рабочего ландшафта.

Обратная связь со сверстниками может быть даже более действенной, чем обратная связь от экспертов, отчасти потому, что новые учащиеся могут лучше объяснять понятия другим учащимся, а отчасти потому, что социальные связи (в том числе профессиональные сети и сообщества ) привносят социальные связи и подкрепление в динамику обучения (узнайте, как оптимизировать обратную связь на онлайн-курсах). Кроме того, Харт указывает, что ключевой особенностью, которая делает этот конкретный аспект успешным, является то, что они выбираются и организуются самими работниками. Этот акт самоотбора и самоорганизации поощряет самодостаточность в непрерывном обучении, что является важным навыком, который необходимо развивать в контексте постоянно меняющегося рабочего ландшафта.

Современный корпоративный тренинг на платформе НовоЭд«Хотя некоторые все еще могут считать, что обучение на рабочем месте — это то, что должно быть организовано и управляемо L&D, не менее важно сосредоточиться на том, чтобы помочь людям стать более самостоятельными и самодостаточными людьми, которые учатся у самых разных источников: контент, люди, события и опыт — как внутри, так и за пределами их организации» — Джейн Харт

Эти высокоценные способы обучения можно поощрять различными способами в организациях. Что касается онлайн-обучения, учебная платформа NovoEd была создана специально для того, чтобы сочетать формальное традиционное электронное обучение с более эффективными подходами к обучению по принципу «равный-равному», выявленным в ходе опроса. Это включает в себя включение реальных проектов на рабочем месте ( основанное на проектах экспериментальное обучение показало, что оно улучшает долгосрочное запоминание контента, а также улучшает навыки решения проблем и совместной работы, Strobel and van Barneveld, 2009) и обучение в небольших группах, что обеспечивает преимущества социального обучения для его участников за счет расширения их профессиональной сети и сообщества , снижения показателей отсева и улучшения навыков общения и сотрудничества (Springer, Stanne, and Donovan, 1999).

Что касается онлайн-обучения, учебная платформа NovoEd была создана специально для того, чтобы сочетать формальное традиционное электронное обучение с более эффективными подходами к обучению по принципу «равный-равному», выявленным в ходе опроса. Это включает в себя включение реальных проектов на рабочем месте ( основанное на проектах экспериментальное обучение показало, что оно улучшает долгосрочное запоминание контента, а также улучшает навыки решения проблем и совместной работы, Strobel and van Barneveld, 2009) и обучение в небольших группах, что обеспечивает преимущества социального обучения для его участников за счет расширения их профессиональной сети и сообщества , снижения показателей отсева и улучшения навыков общения и сотрудничества (Springer, Stanne, and Donovan, 1999).

Действительно, с быстрым темпом технологического роста мир труда постоянно развивается, и каждому необходимо обладать мышлением роста для постоянного самосовершенствования и саморазвития, чтобы выжить и процветать в этом новом мире. . Люди с таким мышлением любят учиться, и эти современные учащиеся все чаще переносят свое обучение в онлайн. Включив социальный обмен проектами и отзывами, мы можем выйти за рамки стандартной функциональности LMS и способствовать неформальному обучению и взаимодействию с коллегами, что приводит к действительно эффективному обучению на современном рабочем месте.

. Люди с таким мышлением любят учиться, и эти современные учащиеся все чаще переносят свое обучение в онлайн. Включив социальный обмен проектами и отзывами, мы можем выйти за рамки стандартной функциональности LMS и способствовать неформальному обучению и взаимодействию с коллегами, что приводит к действительно эффективному обучению на современном рабочем месте.

Зарегистрируйтесь для участия в нашем предстоящем интерактивном туре по продукту, а также в разделе вопросов и ответов , чтобы узнать, как NovoEd позволяет масштабировать лучшее очное онлайн-обучение для сотрудников по всему миру и повышает влияние обучения на ваши бизнес-инициативы.

Если вам понравился этот материал, обязательно ознакомьтесь с другими нашими публикациями о сообществах онлайн-обучения, командных организациях, онлайн-курсах наставничества и формальных и неформальных отзывах.

Похожие запросы

Решения для корпоративного обучения, обучение устойчивому развитию, программа развития лидерства GE, стратегии корпоративного обучения

Хотите больше от НовоЭд? Подпишитесь на наш блог сегодня.

VGhhbmsgeW91IGZvciBzdWJzY3JpYmluZy4=

Похожие сообщения в блоге

Блог

Прочитай сейчас

СтрелкаБлог

Платформы обучения: что такое LXP?

Что такое платформа обучения? Мы рассматриваем примеры обучения как LMS, так и LXP, а также третий вариант сочетания и развития лучшего из обоих.

Прочитай сейчас

СтрелкаБлог

Прочитай сейчас

СтрелкаБлог

Прочитай сейчас

СтрелкаБлог

Прочитай сейчас

СтрелкаБлог

Прочитай сейчас

СтрелаTraining Models — документация h3O 3.38.0.1

h3O поддерживает обучение моделей с учителем (где переменная результата известна) и моделей без учителя (немаркированные данные). Ниже мы приводим примеры классификации, регрессии, кластеризации, уменьшения размерности и обучения на сегментах данных (обучаем набор моделей — по одной для каждого раздела данных).

Обучение с учителем

Алгоритмы обучения с учителем поддерживают задачи классификации и регрессии.

Классификация и регрессия

В задачах классификации выходная или «ответная» переменная является категориальным значением. Ответ может быть бинарным (например, да/нет) или мультиклассовым (например, собака/кошка/мышь).

В задачах регрессии выходная переменная или переменная «отклик» представляет собой числовое значение. Примером может служить предсказание чьего-то возраста или продажной цены дома.

Классификация и регрессия в моделях h3O : Способ, которым вы сообщаете h3O, хотите ли вы выполнить классификацию или регрессию для конкретного контролируемого алгоритма, заключается в кодировании столбца ответа либо как категориальный/факторный тип (классификация), либо как числовой тип. (регрессия). Если ваш столбец представлен в виде строк («да», «нет»), то h3O автоматически закодирует этот столбец как категориальный/факторный тип (также известный как «перечисление») при импорте набора данных. Однако, если у вас есть столбец с целыми числами, который представляет класс в задаче классификации (0, 1), вам придется изменить тип столбца с числового на категориальный/факторный (также известный как «перечисление»). Причина, по которой h3O требует, чтобы столбец ответа был закодирован как «правильный» тип для конкретной задачи, заключается в максимальной эффективности алгоритма.

Однако, если у вас есть столбец с целыми числами, который представляет класс в задаче классификации (0, 1), вам придется изменить тип столбца с числового на категориальный/факторный (также известный как «перечисление»). Причина, по которой h3O требует, чтобы столбец ответа был закодирован как «правильный» тип для конкретной задачи, заключается в максимальной эффективности алгоритма.

Пример классификации

В этом примере используется набор данных Prostate и алгоритм GLM h3O для прогнозирования вероятности того, что у пациента будет диагностирован рак простаты. Набор данных включает следующие столбцы:

ID : Идентификатор строки. Его можно исключить из списка предикторов.

КАПСУЛА : проникла ли опухоль в капсулу предстательной железы

ВОЗРАСТ : Возраст пациента 9 лет0005

РАССА : Раса пациента

DPROS : Результат пальцевого ректального исследования, где 1 = узел отсутствует; 2 = однодольный узел слева; 3 = односторонний узел справа; и 4 = билобарный узел.

DCAPS : Имелось ли поражение капсулы при ректальном исследовании

ПСА : Уровень специфического антигена простаты (мг/мл)

ТОМ : Объем опухоли (см3)

GLEASON : Оценка пациента по шкале Глисона в диапазоне от 0 до 10

В этом примере для прогнозирования используются только столбцы AGE, RACE, VOL и GLEASON.

Python

библиотека (h3o)

h3o.init()

# импортируем набор данных простаты

df <- h3o.importFile("https://h3o-public-test-data.s3.amazonaws.com/smalldata/prostate/prostate.csv")

# преобразовать столбцы в множители

df$CAPSULE <- as.factor(df$CAPSULE)

df$RACE <- as.factor(df$RACE)

df$DCAPS <- as.factor(df$DCAPS)

df$DPROS <- as.factor(df$DPROS)

# установить столбцы предиктора и ответа

предикторы <- c("ВОЗРАСТ", "РАС", "ОБЪЕМ", "ГЛИСОН")

ответ <- "КАПСУЛА"

# разделить набор данных на обучающий и тестовый наборы

df_splits <- h3o. splitFrame (данные = df, ratios = 0,8, seed = 1234)

поезд <- df_splits[[1]]

тест <- df_splits[[2]]

# построить модель GLM

prostate_glm <- h3o.glm(family = "биномиальный",

х = предикторы,

у = ответ,

тренировочный_кадр = дф,

лямбда = 0,

вычисление_p_значения = ИСТИНА)

# прогнозировать, используя модель GLM и набор данных для тестирования

предсказать <- h3o.predict (объект = prostate_glm, новые данные = тест)

# просмотреть сводку прогнозов

h3o.head(предсказать)

предсказать p0 p1 StdErr

1 1 0,5318993 0,46810066 0,4472349

2 0 0,7269800 0,27302003 0,4413739

3 0 0,76 0,098 0,3528526

4 0 0,37 0,09370628 0,2874410

5 1 0,6414760 0,35852398 0,2719742

6 1 0,5092692 0,480 0,4007240

splitFrame (данные = df, ratios = 0,8, seed = 1234)

поезд <- df_splits[[1]]

тест <- df_splits[[2]]

# построить модель GLM

prostate_glm <- h3o.glm(family = "биномиальный",

х = предикторы,

у = ответ,

тренировочный_кадр = дф,

лямбда = 0,

вычисление_p_значения = ИСТИНА)

# прогнозировать, используя модель GLM и набор данных для тестирования

предсказать <- h3o.predict (объект = prostate_glm, новые данные = тест)

# просмотреть сводку прогнозов

h3o.head(предсказать)

предсказать p0 p1 StdErr

1 1 0,5318993 0,46810066 0,4472349

2 0 0,7269800 0,27302003 0,4413739

3 0 0,76 0,098 0,3528526

4 0 0,37 0,09370628 0,2874410

5 1 0,6414760 0,35852398 0,2719742

6 1 0,5092692 0,480 0,4007240

импорт воды

h3o.init()

из h3o.estimators.glm импортировать h3OGeneralizedLinearEstimator

# импортируем набор данных простаты

простата = h3o.import_file("https://h3o-public-test-data. s3.amazonaws.com/smalldata/prostate/prostate.csv")

# преобразовать столбцы в множители

простата['КАПСУЛА'] = простата['КАПСУЛА'].asfactor()

простата['ГОНКА'] = простата['ГОНКА'].asfactor()

простата['DCAPS'] = простата['DCAPS'].asfactor()

простата['DPROS'] = простата['DPROS'].asfactor()

# установить столбцы предиктора и ответа

предикторы = ["ВОЗРАСТ", "ГОНКА", "ОБЪЕМ", "ГЛИСОН"]

response_col = "КАПСУЛА"

# разделить на наборы для обучения и тестирования

поезд, тест = prostate.split_frame (соотношения = [0,8], начальное число = 1234)

# установить параметры моделирования GLM

# и инициализируем обучение модели

glm_model = h3OGeneralizedLinearEstimator(family= "биномиальный",

лямбда_ = 0,

calculate_p_values = Истина)

glm_model.train (предикторы, response_col, training_frame = простата)

# предсказать, используя модель и набор данных для тестирования

предсказать = glm_model.predict (тест)

# Просмотр сводки прогноза

предсказать.

s3.amazonaws.com/smalldata/prostate/prostate.csv")

# преобразовать столбцы в множители

простата['КАПСУЛА'] = простата['КАПСУЛА'].asfactor()

простата['ГОНКА'] = простата['ГОНКА'].asfactor()

простата['DCAPS'] = простата['DCAPS'].asfactor()

простата['DPROS'] = простата['DPROS'].asfactor()

# установить столбцы предиктора и ответа

предикторы = ["ВОЗРАСТ", "ГОНКА", "ОБЪЕМ", "ГЛИСОН"]

response_col = "КАПСУЛА"

# разделить на наборы для обучения и тестирования

поезд, тест = prostate.split_frame (соотношения = [0,8], начальное число = 1234)

# установить параметры моделирования GLM

# и инициализируем обучение модели

glm_model = h3OGeneralizedLinearEstimator(family= "биномиальный",

лямбда_ = 0,

calculate_p_values = Истина)

glm_model.train (предикторы, response_col, training_frame = простата)

# предсказать, используя модель и набор данных для тестирования

предсказать = glm_model.predict (тест)

# Просмотр сводки прогноза

предсказать. head()

предсказать p0 p1 StdErr

--------- -------- --------- --------

1 0,531899 0,468101 0,447235

0 0,72698 0,27302 0,441374

0 0,8 0,09 0,352853

0 0,4 0,0937063 0,287441

1 0,641476 0,358524 0,271974

1 0,509269 0,4

head()

предсказать p0 p1 StdErr

--------- -------- --------- --------

1 0,531899 0,468101 0,447235

0 0,72698 0,27302 0,441374

0 0,8 0,09 0,352853

0 0,4 0,0937063 0,287441

1 0,641476 0,358524 0,271974

1 0,509269 0,4Пример регрессии

В этом примере используются данные Boston Housing и алгоритм GLM h3O для прогнозирования средней цены дома с использованием всех доступных функций. Набор данных включает следующие столбцы:

преступность : Уровень преступности на душу населения по городам

zn : Доля жилых земель, зонированных под участки площадью более 25 000 кв. футов

indus : Доля неторговых площадей в акрах на город

час : фиктивная переменная реки Чарльз (1, если участок ограничивает реку Чарльз; 0 в противном случае)

nox : Концентрация оксидов азота (частей на 10 миллионов)

п.

м. : Среднее количество комнат в жилом помещении

м. : Среднее количество комнат в жилом помещенииВозраст : Доля домов, построенных до 1940 года

dis : Взвешенные расстояния до пяти центров занятости Бостона

рад : Индекс доступности радиальных магистралей

налог : Полная ставка налога на имущество за 10 000 долларов США

- 92, где Bk — доля чернокожего населения

lstat : Низкий статус населения в %

medv : Средняя стоимость домов, занимаемых владельцами, в 1000 долларов США

Python

библиотека (h3o) h3o.init() # импортируем бостонский набор данных: # этот набор данных рассматривает особенности пригородов Бостона и прогнозирует средние цены на жилье # исходный набор данных можно найти по адресу https://archive.ics.uci.edu/ml/datasets/Housing бостон <- h3o.importFile("https://s3.amazonaws.com/h3o-public-test-data/smalldata/gbm_test/BostonHousing.csv") # устанавливаем имена предикторов и имя столбца ответа предикторы <- colnames(Бостон)[1:13] # этот пример будет предсказывать столбец medv # вы можете запустить следующее, чтобы увидеть, что medv действительно является числовым значением h3o.isnumeric(Бостон["медв"]) [1] ИСТИНА # установите столбец ответа на «medv», что является средней стоимостью домов, занимаемых владельцами, в 1000 долларов. ответ <- "медв" # преобразовать столбец `chas` в коэффициент # `chas` = фиктивная переменная Charles River (= 1, если участок ограничивает реку; 0 в противном случае) бостон["час"] <- as.factor(бостон["час"]) # разделить на обучающий и тестовый наборы boston_splits <- h3o.splitFrame(data = boston, ratios = 0,8, seed = 1234) поезд <- boston_splits[[1]] тест <- boston_splits[[2]] # устанавливаем параметр `alpha` на 0,25 и обучаем модель boston_glm <- h3o.glm(x = предикторы, у = ответ, training_frame = поезд, альфа = 0,25) # прогнозировать, используя модель GLM и набор данных для тестирования предсказать <- h3o.